1.はじめに

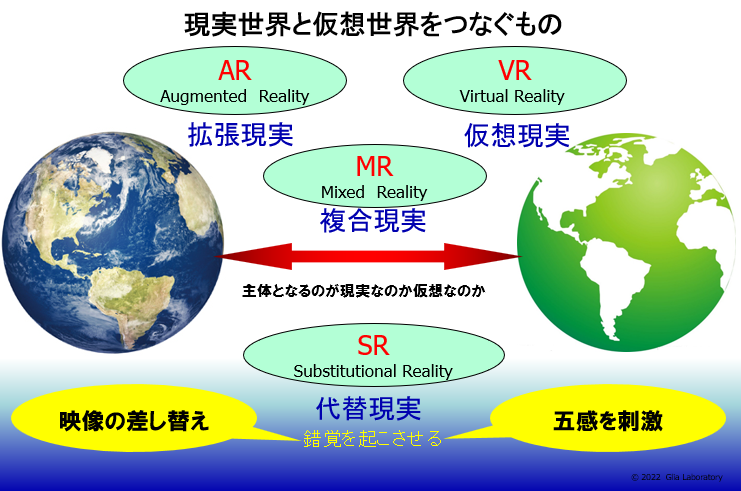

拡張現実(AR:Augmented Reality)[1]とは、実写の映像にアノテーション(デジタルの情報)を重ね合わせて利用者をサポートするインターフェイスのことです。携帯デバイスの高性能、低価格化に伴い、今では誰もが手にすることのできるインターフェイスとなってきて、最新テクノロジーの黎明期のようにもてはやされています。しかし歴史を振り返ると、この技術の目指すところはコンピュータの出現とほぼ同時期から人類が夢みて、繰り返し取り組まれてきた技術です。技術の進歩は拡張現実を一定の水準に引き上げることができましたが、社会の中で定着し、将来安定した技術プラットフォームとなる為には何が必要なのでしょうか。例えばiPhoneアプリである「セカイカメラ」[2]に代表されるように、法人向けや一般ユーザー向けのサービスも増加しています。身近に体験することが可能になり、ビジネスの場に活用しようという動きも活発な拡張現実ですが、数年前にはセカンドライフに代表される仮想現実(VR:Virtual Reality)の世界が脚光を浴びていました。仮想現実は陰影の処理をするシェーダモデルや、物の動きをシミュレートするHAVOX等の物理エンジンにより、仮想の世界をリアルな現実世界に近づけようとしていました。一方、拡張現実は現実世界にデジタル情報を付加する逆方向のアプローチであり現実世界が主体となっています。さらに2009年にオリンピック誘致活動の一環で、招待したIOC委員に渡したゴーグルを通して見ると、会場予定地に将来のスタジアムが現実の風景に溶け込んで表示されました。これは現実世界と仮想世界の両方が主体であり複合現実(MR:Mixed Reality)と呼ばれます。これら3つの技術AR、VR、MRはすべて現実世界と仮想世界を融合する仕組みです。現実世界が仮想世界、すなわちコンピュータと直結されると言う意味ではRFIDを使ったソリューションと同様にユビキタス社会へ向けての重要基盤となる技術と捉えることができます。長い目で見た時、拡張現実は今後どのような方向に進化していくのでしょうか、またその為に何が必要となるのかを考察してみます。

2.拡張現実の歴史

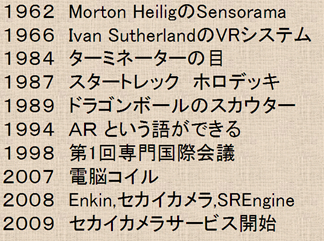

日本で拡張現実という言葉が普及したのは2007年にNHKで放映された「電脳コイル」の影響と言われています。「電脳メガネ」をかけて見ると現実には存在していないデジタルのペットや道具が現れるのですが、現実世界と仮想世界が融合されるこのコンセプトはずっと以前から存在していました。拡張現実のwikiのページ[3]を参照すると拡張現実の歴史として最古の記事は1936年Konrad Zuseによる最初のデジタルコンピュータZ1の発明とありますが、もう少し拡張現実のイメージに近いものを探すと、おそらく最初の拡張現実と呼んで良い事例は1962年の Morton Heiligによる「Sensorama」を挙げることができます。このシステムはゲームセンターにあるバイクやカーレースの機械に似ていました。被験者はバイクを運転しているつもりで映写されている風景の中を運転するのですが仮想のスピードに合わせて扇風機による風が体験され、さらに花畑の横を通る時には花の香が漂うという仕組みまで作り込んでありました。次に古いものとしては1966年のIvan SutherlandのVRシステムがあります。世界で最初のVR/ARと呼ばれる「The Ultimate Display」は半透明鏡を使って光学的に映像を重ね合わせる仕組みでしたが、当時の写真を見ても非常に大がかりな装置で、誰でもが体験できるようなものではありませんでした。その後、ターミネーターの目やドラゴンボールのスカウター等SF映画やアニメの中で拡張現実の技術が表現されていますが、拡張現実(AR)という言葉ができたのは実は1994年のことです。その間、軍事分野では戦闘機のヘッドアップディスプレイやヘッドマウントディスプレイが改良を重ねていましたが、一般の人が実用レベルの拡張現実を体験できるようになったのは、おそらく2000年にトヨタ・ソアラに搭載されたバックガイドモニターでしょう。バックする時に後方映像中に車両の移動予想位置を表示して運転操作をサポートする装置ですが、これはまさに拡張現実の適用例と言えます。しかし戦闘機や車の中と言った限定された状況下での利用局面から、いつでも、誰でもが利用できる技術へと飛躍したのは2007年に相次いで発表されたアップル社のiPhoneとGoogle社の携帯端末用OS Androidの出現が大きく影響しています。GPSによる位置情報や電子コンパスなどのセンサー情報を、小型の携帯端末で利用可能となったことで拡張現実のアプリケーションは一気に身近な道具としての地位を確立することとなり、そのサービス内容も飛躍的に増加しています。

3.拡張現実の要素技術

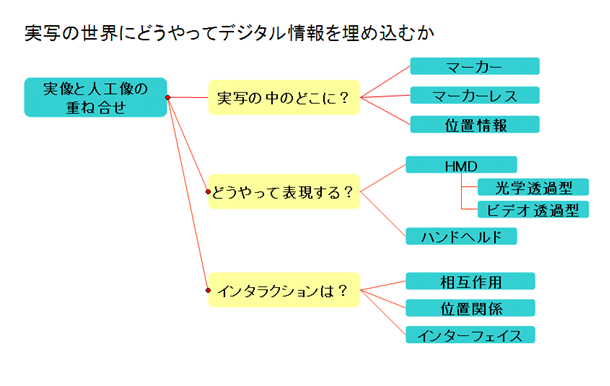

拡張現実を実現する技術的要素は以下の3点が挙げられます。

- オブジェクトマッピング

実写映像中のどこにデジタル情報を重ね合わせれば良いのか。 - 表示デバイス

デジタル情報を表示するデバイスの選択

- インタラクション(相互作用)

実像中に表示されたデジタルオブジェクトとのインタラクション方法

以下、それぞれの現状と課題について整理します。

3.1 オブジェクトマッピング

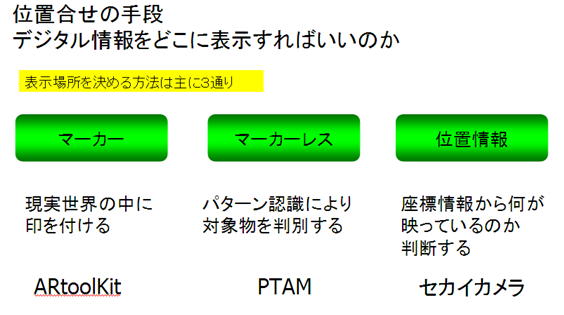

実写映像へのデジタル情報マッピングの方法は大別して3種類あります。

- マーカー

- マーカレス

- 位置情報

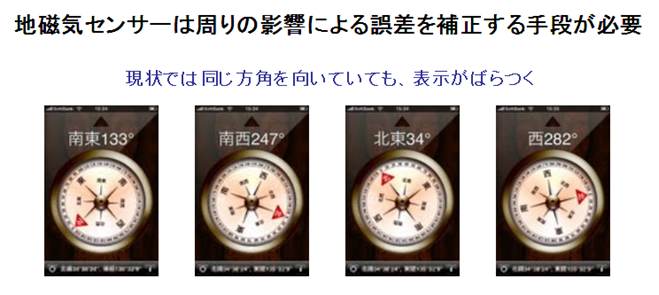

マーカーを利用する方法は、現実世界の中にマーカーと呼ぶ目印を付け、そのマーカーを基準にしてデジタル情報を表示します。奈良先端科学技術大学院大学の加藤博一教授が開発したARtoolKitを利用すると比較的容易にARアプリケーションを開発することが可能です。マーカーを使う方法では、事前に現実世界の中にマーカーを埋め込んでおく必要があるので、自由にどこにでもデジタル情報を表示するという柔軟性はありません。また情報発信できる人も限定される為、利用用途としては、大日本印刷社の「飛び出す電子絵本」のように本やパンフレットに埋め込んで表現力を拡張する利用例や博物館、美術館などでのナビゲーション等が挙げられます。マーカーレスという方法は実像の中から特徴点を抽出しパターン認識することで、対象となるオブジェクトを判別する方法です。オックスフォード大学のGeorg Kleinらによって研究・開発されたPTAM (Parallel Tracking and Mapping)[4]を使うと実写の映像中からリアルタイムに特徴点を抽出し、3Dのパターンを認識することで自然なデジタルオブジェクトの表示が可能となります。この方法での課題はパターン認識方法と認識率です。現実世界の中には多くの類似した形のオブジェクトが存在します。無限に近い映像パターンの中から特定のパターンを認識することは難しい為、マーカー型と同様に限定された場所、あるいは状況下での利用となるでしょう。3つ目は位置情報に基づきデジタル情報を表示する場所を判断する方法で「セカイカメラ」等で利用している方法です。GPSの位置情報には誤差がある為、街中などでの大まかなガイドは可能でも、正確な位置に基づくオブジェクトの重ね合わせは難しいのが現状です。さらにGPSによる位置情報が正確であっても、カメラで映している映像がどちらを向いているのかを知るためには電子コンパス等の情報も必要となります。「セカイカメラ」では位置情報と電子コンパスの情報を使って、ある場所からどちらを見た時の映像かを判断し、エアタグと呼ぶデジタル情報を表示していますが、電子コンパスは周辺地場の影響を受ける為、正確な方角を知ることは非常に難しいことです。

また正確に、ある物体を認識してその関連情報を表示したい場合にはカメラに写っている物体の形や距離、場合によっては色の判断も必要となってきます。現在の技術で拡張現実を追及するならパターン認識と位置情報に基づく方法、そして場合によってはマーカーを併用するハイブリッド方式で実装することが望ましいと言えます。

- 表示デバイス

拡張現実のアプリケーションでは目の前の現実映像を表示するデバイスと、その映像にデジタル情報を重ねて表示する仕組みが必要です。

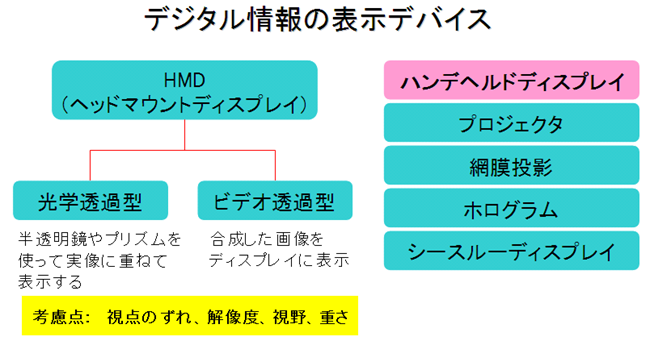

現状ではハンドヘルドディスプレイ(モバイル端末のディスプレイ)にカメラ映像とデジタル情報を重ねて表示することになりますが、移動しながらの利用には向いていません。HMD(ヘッドマウントディスプレイ)を使うと拡張現実のアプリケーションを利用しながら移動することが容易になりますが、解像度や視点のずれ、視野の広さ、そして長時間の使用に耐える軽さなどの課題があります。また実視界を遮るような表示は安全性の観点で非常に大きな課題となります。将来的にはディスプレイを使用せずに直接網膜に投影する技術や、さらに未来では直接、脳への入力が可能となるかもしれません。

- インタラクション

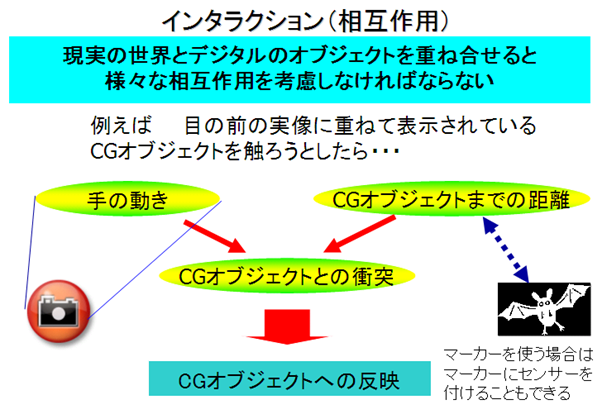

現実の世界とデジタルのオブジェクトが重ね合わされると、次に自然な要求としてインタラクションが求められるようになるでしょう。インタラクションは実写映像中に表示されたデジタルオブジェクトに対して何らかのアクションを起こす場合と、ディスプレイ越しに手を伸ばし、現実には存在していないはずの空間に対して行うものがあります。ハンドヘルドディスプレイ上に表示されているオブジェクトに対しては、タッチパネルや端末側のインターフェイスを通してインタラクションを起こすことは比較的容易ですが、空間上に重ね表示された仮想のオブジェクトに対してインタラクションを起こす為には、手の動き、オブジェクトまでの距離、オブジェクトとの衝突シミュレーション及びその結果のデジタルオブジェクトへの反映など複雑な技術が必要となります。

4.拡張現実の適用分野

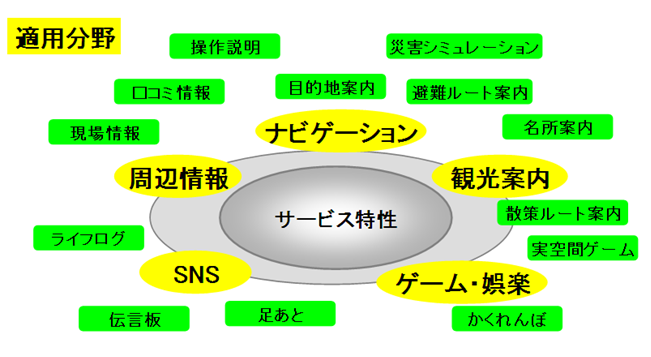

拡張現実のアプリケーションは小型高機能の端末の出現により、様々なサービス提供が始まっています。2009年9月、「セカイカメラ」のサービス開始に伴い、一躍脚光を浴びていますが、実は2008年にGoogle社の企画したAndroid Developer Challengeではドイツの学生が「Enkin」と呼ばれるAndroid端末向けの拡張現実感のナビゲーションソフトが発表されていました。またIBM社でも2009年6月に拡張現実ソフト「IBM Seer」を発表しWimbledon2009の会場案内のサービスを提供していました。

現在では数多くの拡張現実サービスが乱立し、中にはタッチパネル上でデジタルオブジェクトに対してインタラクションを起こせるものも出てきています。ゲームの世界では任天堂DSi用の幽霊狩りゲーム「Ghostwire」やソニー・コンピュータエンタテインメントのPSP用 「Invizimals」など身近な風景の中に幽霊やモンスターを出現させる、まさに現実を拡張させた世界が体験できるようになってきました。現時点で拡張現実はナビゲーション、周辺情報提供、観光案内の他、伝言版や「足あと」と言ったSNS分野、そしてゲーム・娯楽の分野での活用例が増加しています。

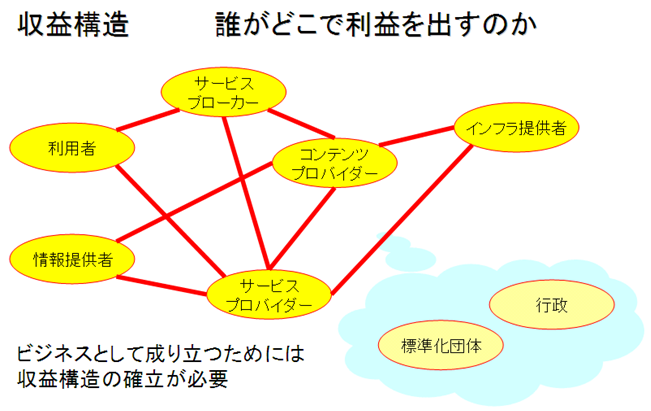

しかし拡張現実の技術が将来に渡って安定した技術として定着できるかどうかは、ビジネスとして成り立つかどうかに依存します。面白いだけでは一時的な人気で終わってしまうので、サービスにおける登場人物と役割分担を明確にして収益構造を確立しなければなりません。拡張現実サービスにおける役割は図-9のように利用者とサービスプロバイダー以外に情報提供者、コンテンツプロバイダー、サービスブローカー、そしてデバイスメーカーとインフラ提供者が存在します。それぞれの役割が何の名目で利益を得るのか、現状では利用者が直接利用料金を支払うサービスはまだ未成熟であり、サービスの価値を追及していく必要があると考えられます。当然ながら、利用目的が企業内の業務効率化の場合もあります。直接的な営利目的ではない工場見学コースやイベント会場ガイド等もあり、一般消費者向けのキャンペーンなどでの活用も大きなポテンシャルを持っています。しかしながら技術向上を継続的に取り組んで行く為には必ず、コスト負担をするのが誰なのかを明確にしていかなければなりません。

5.拡張現実の利活用の可能性

例えば「セカイカメラ」のようにユーザー自身が映像中に情報を書き込むことのできるサービスでは伝言版のような、SNS的利用も可能です。六軸センサーの搭載や地磁気センサーの補正技術などの進歩が期待されますが、ユーザーインターフェイスも大きく進化する必要性があります。脳波入力、筋電入力、網膜投影などの実験が行われていますが、2009年10月にはついに米ベンチャー企業のニューロスカイ社が脳波測定ヘッドセット「MindSet」[5]を発売し、既に対応するゲームが出始めています。将来は脳波を使ったインターフェイスで現実世界と仮想世界の境界はさらに曖昧なものとなっていく可能性があるのです。現在の拡張現実のアプリケーションはカメラでとらえた映像に対して、情報を付加する使い方が多いのですが、インターフェィスが高度化すれば、リアルタイムの映像にデジタルのオブジェクトを重ね合せ、さらにそのデジタルオブジェクトに対するインタラクションが可能となります。例えば特定の場所で認証されたユーザーのみが仮想の鍵を使って現実には鍵穴の無いドアを開けたり、現実には存在していないオブジェクトを操作することで、現実世界を操作することができるようになります。拡張現実端末に内蔵されたICタグと連携してトレーサビリティ・アプリケーションと融合したサービスも提供可能となるでしょう。触感をフィードバックする研究も行われているので、これが実用レベルの技術となれば博物館や美術館では実写映像に重ねられたデジタルの作品に触ることができるようになります。仮想世界(VR)、拡張現実(AR)、複合現実(MR)が渾然一体となり仮想世界と現実世界をより緊密に連携したアプリケーションが出現するのです。拡張現実はリアルタイムの映像に対するインターフェイスですが、仕組み的には蓄積された映像に対しても同様のサービスが可能です。例えば日本IBMの杉本技術理事の開発したPhotoVRは位置情報に基づき構成されたフォトスペース(パノラマ写真空間)が舞台ですが、技術的には実写の映像からシームレスにパノラマのフォトスペースに入って行き、ユーザーは写真で作られた現実世界のコピーの中を時間軸に沿って見て回る事も可能となります。そしてその中に表示されたデジタルオブジェクトを触って動かしてみたりすることも可能となるのですが、それらのインタラクションを通じて、ユーザーが興味を持った内容を分析し、次に何を知りたいか、何をしたいかを予測してコンテキスト・アウェアネス・ナビゲーションを行なうことも可能になるでしょう。つまり現実世界に加えて仮想世界の中でも、ユーザーの自然な振舞いの中から未来予測を行い、先回りしたサービスを提供することが可能となるのです。実経験不可能な大規模災害時の行動パターン分析に利用すれば、その災害が現実となった時に何が起こるのかを事前に検証することも可能となります。脳波計等の生体センサー情報を活用すると、現実世界は仮想世界だけでなく精神世界とも相互作用を起こすことが可能となってくるかもしれません。このような事が実現されれば、もはや「ユビキタス社会」という枠組みさえ超えた超現実の世界が出現するのです。

6.おわりに

拡張現実は仮想現実と同様に、現実と仮想の世界を融合しようという試みです。IBMとNOKIA社はフィンランドのAR+OpenSimプロジェクトでこれら2つの世界をさらに融合する共同研究を行っています。(Augmented Collaboration in Mixed Environments )[6] このプロジェクトでは、セカンドライフの仮想世界と現実世界を拡張現実を使って融合します。例えばリモート参加者がセカンドライフにログインしてメタバース内の会議室に入室すると現実の会議室に居る参加者の「電脳メガネ」を通して見ると、リモート参加者のアバターがそこに出現したかのように見せる試みです。

仮想世界が今後さらにリアルな表現力を実現すれば、現実世界と仮想世界はシームレスに繋がり区別することが難しい時代が来るかもしれません。コンピュータが生まれた時から、人類はコンピュータの中の世界と現実の世界を繋げる努力をしてきました。人工知能と呼ぶ人類と同格の存在を作ろうとしたり、相互補完する仕組みを作ったりしてきたのです。拡張現実もその中のひとつの試みです。しかし技術が進歩してコンピュータの作った世界と現実の世界の区別がつかなくなると非常に危険でもあります。多くの課題とともに一定の倫理感を持って慎重に取り組んでいくべき技術であることを忘れてはなりません。

参考文献

[1]AR拡張現実

フリー百科事典『ウィキペディア(Wikipedia)』(2011/02/06時点)

[2]AR History

[3]PTAM

[4]Mindset

[5] Augmented Collaboration in Mixed Environments

[6]書籍「ARのすべて」

ISBN978-4-8222-1083-0

コメント